windows 本地部署DeepSeek + 配置AnythingLLM

windows 本地部署DeepSeek + 配置AnythingLLM

本教程是通过在windows下安装和部署Ollama、DeepSeek模型、AnythingLLM来使用DeepSeek,三者存在以下关系:Ollama是大模型服务工具,用于简化在本地运行大语言模型,其在整个流程中扮演着基础架构的角色,用于获取预训练的语言模型如DeepSeek并提供必要的开发环境支持;AnythingLLM作为应用层框架,与Ollama之间形成工具链式协作关系,允许开发者将自己的定制化模型集成进来,并提供了友好的用户界面,方便配置、管理和使用。

安装

ollama

Ollama是一个开源的 LLM(大型语言模型)服务工具,用于简化在本地运行大语言模型,降低使用大语言模型的门槛,使得大模型的开发者、研究人员和爱好者能够在本地环境快速实验、管理和部署最新大语言模型,包括如DeepSeek、Llama、Phi、Mistral、Gemma、QWen等开源的大型语言模型。

安装ollama

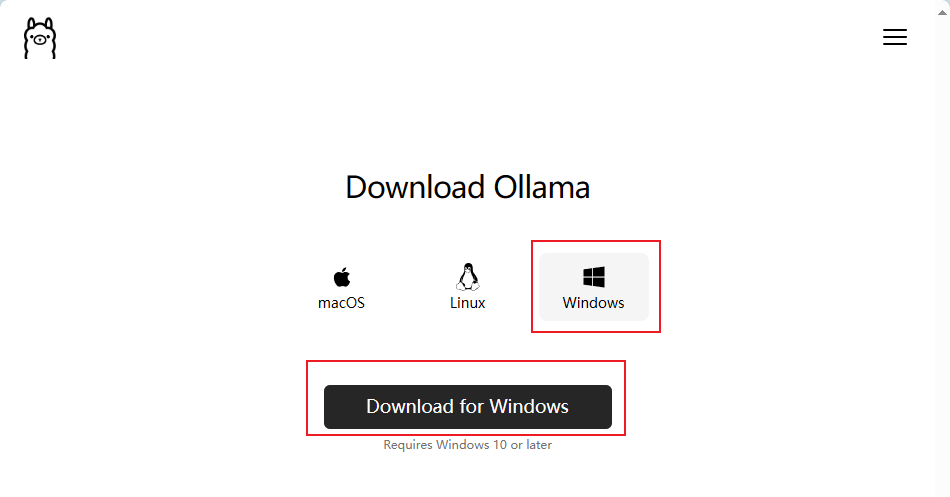

官网下载: https://ollama.com/download

选择windows,下载

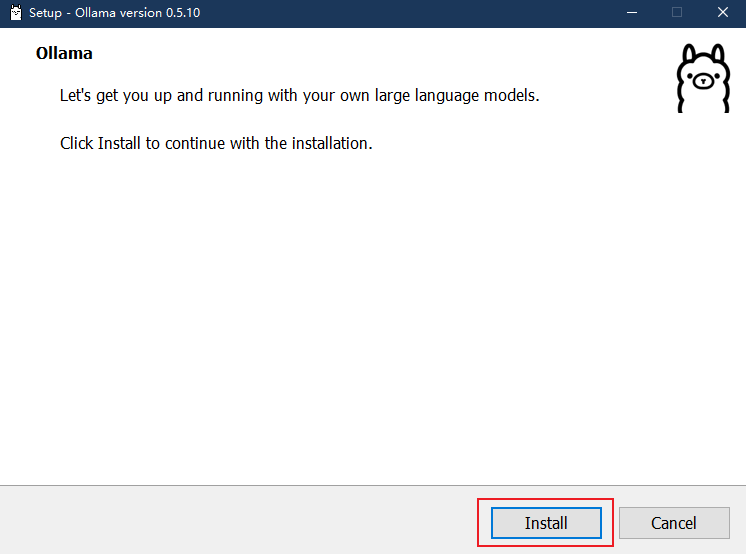

安装

会自动安装到C盘,不过软件本体不大,所以无伤大雅,而且官方也暂时没有给出更改方法。

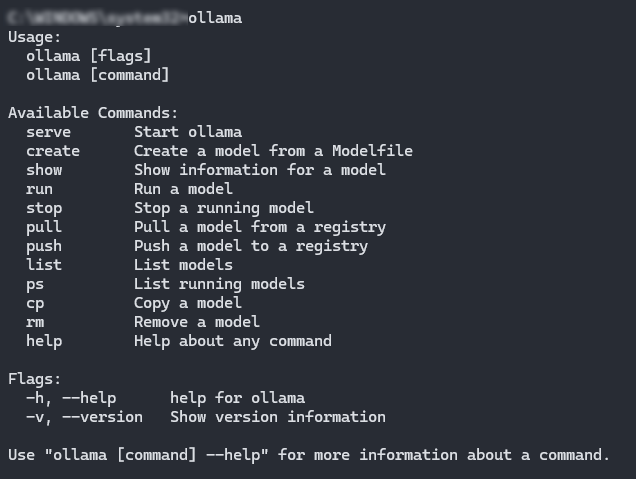

安装完成后,检查是否可以使用:

打开命令行终端,输入 ollama,可以看到帮助提示

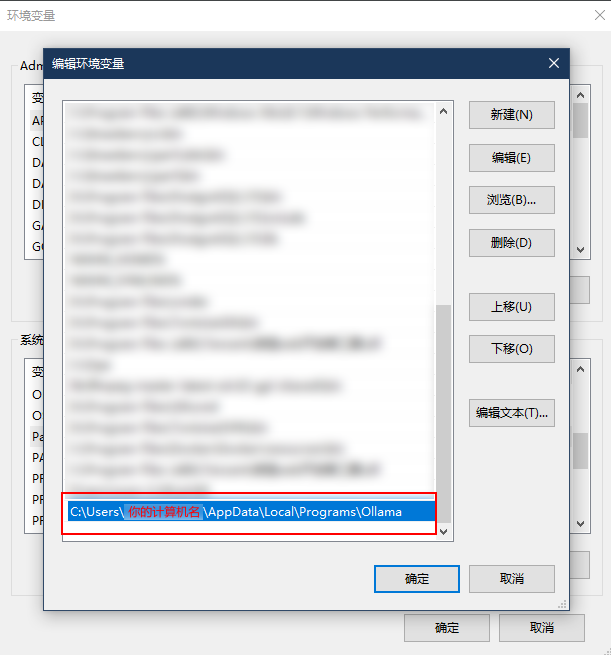

报错'ollama' 不是内部或外部命令,也不是可运行的程序或批处理文件。

解决:配置环境变量,首先找到ollama安装位置,默认位置在C:\Users\你的计算机名\AppData\Local\Programs\Ollama,复制这个路径,添加到系统环境变量path中

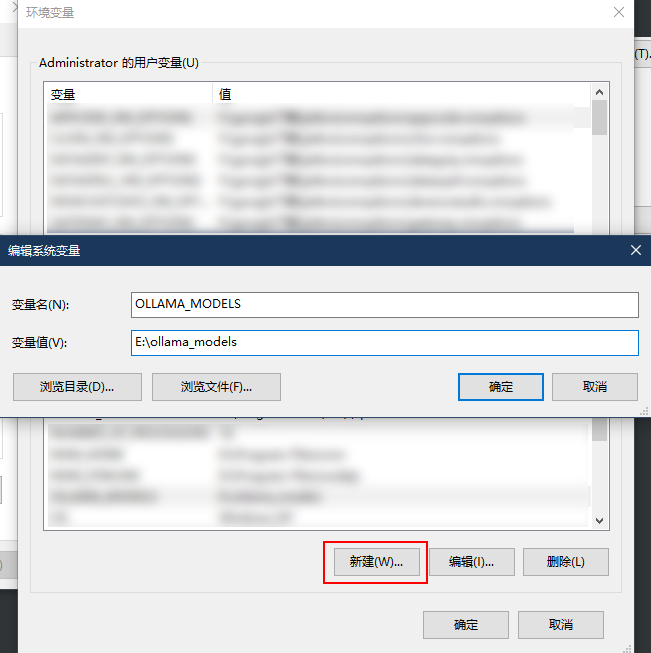

*重点:修改ollama模型下载位置

ollama会默认将模型下载到C盘,如果空间不够,这一步就是必需的。

添加环境变量,变量名为OLLAMA_MODELS,值可以自定义,添加后重启电脑

deepseek-r1

deepseek-r1 是 DeepSeek 推出的推理模型。在输出最终回答之前,模型会先输出一段思维链内容,以提升最终答案的准确性。

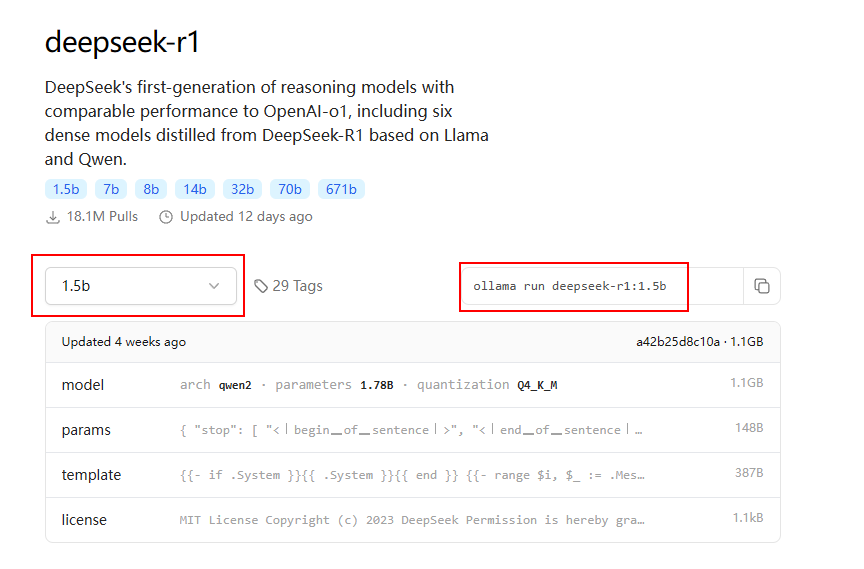

下载模型

使用ollama安装大语言模型,打开ollama官网的模型列表,选择deepseek-r1,根据自己电脑性能选择模型大小,复制ollama命令

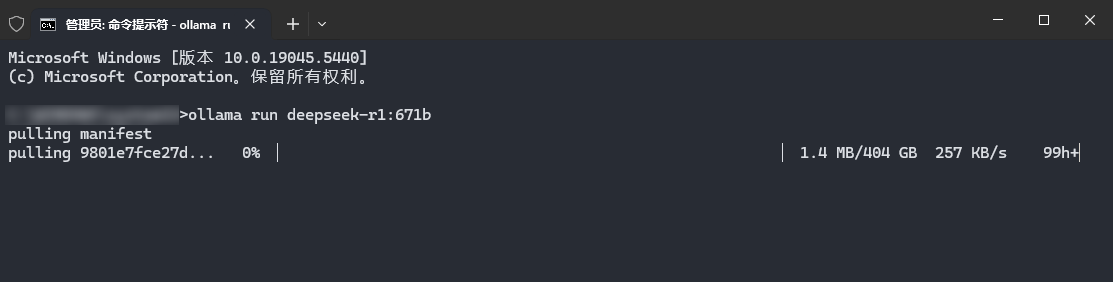

在cmd命令行执行可以看到正常下载

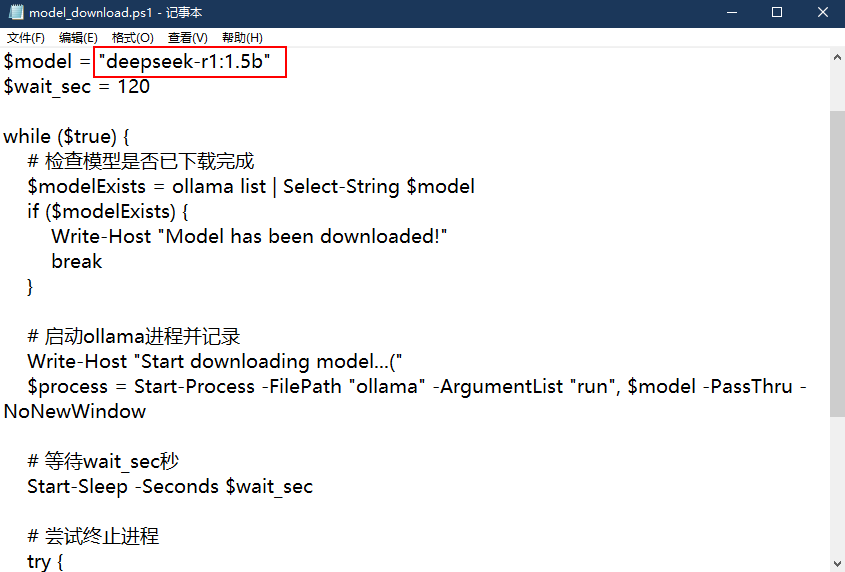

不过这种方式非常慢,经过尝试发现模型在一开始下载很快,过一会速度就降下来了,因此可以使用脚本,每120s中断一次,再重新开始下载,这样能保证始终以峰值速度下载

$model = "deepseek-r1:1.5b"

$wait_sec = 120

while ($true) {

# 检查模型是否已下载完成

$modelExists = ollama list | Select-String $model

if ($modelExists) {

Write-Host "Model has been downloaded!"

break

}

# 启动ollama进程并记录

Write-Host "Start downloading model...("

$process = Start-Process -FilePath "ollama" -ArgumentList "run", $model -PassThru -NoNewWindow

# 等待wait_sec秒

Start-Sleep -Seconds $wait_sec

# 尝试终止进程

try {

Stop-Process -Id $process.Id -Force -ErrorAction Stop

Write-Host "This download has been interrupted, ready to try again...("

}

catch {

Write-Host "The process has ended without interruption.("

}

}

将脚本保存为.ps1文件,修改$model值为想要下载的模型名,模型名即前面复制的ollama命令ollama run deepseek-r1:1.5b最后一部分deepseek-r1:1.5b

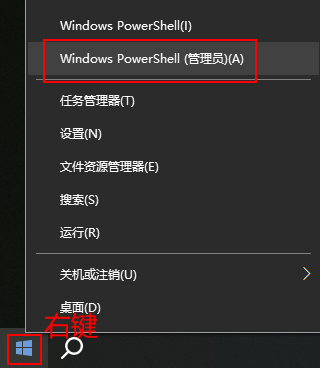

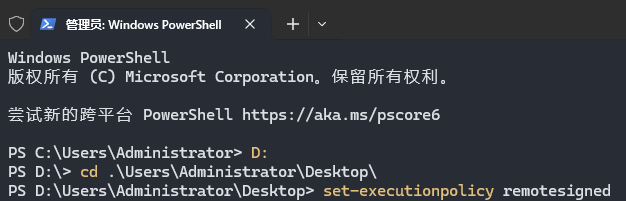

以管理员身份打开powershell

进入到脚本所在目录,执行set-executionpolicy remotesigned以允许运行自定义脚本

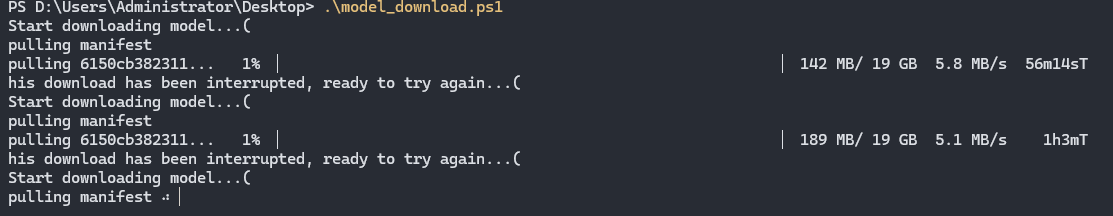

运行脚本,可以看到脚本每120s自动中断并重新开始

等待下载时可以打开上一步设置的ollama下载位置,如果出现一些文件则说明设置生效了

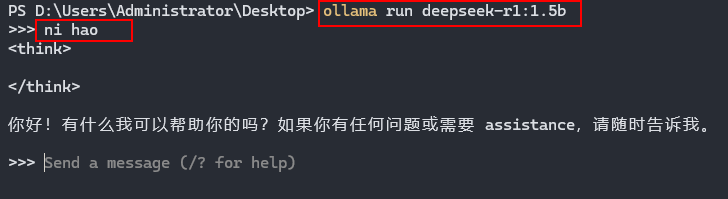

下载完成后提示Model has been downloaded!,或自动进入模型的命令行对话,如果没有进入,再执行依次ollama命令,如ollama run deepseek-r1:1.5b,任意提问测试一下,可以正常回复,则模型安装成功

单纯的命令行使用很难发挥模型的最佳能力,因此需要借助一些LLM UI工具,例如AnythingLLM

AnythingLLM

AnythingLLM 是开源免费且支持多模态交互的全栈 AI 客户端。 AnythingLLM支持文本、图像和音频等多种输入方式,将任何文档或内容转化为上下文,供各种语言模型(LLM)在对话中使用。 AnythingLLM支持本地运行和远程部署,提供多用户管理、工作区隔离、丰富的文档格式支持以及强大的 API 集成。 所有数据默认存储在本地,确保隐私安全。

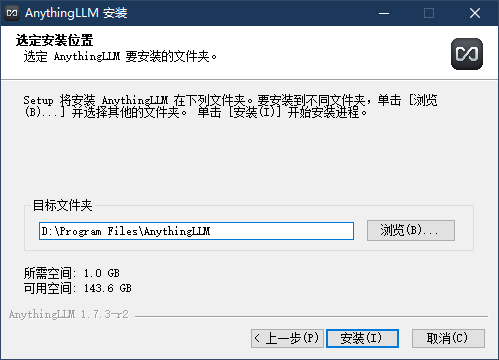

安装AnythingLLM

官网下载Download AnythingLLM for Desktop

安装位置可以改一下

等待个5 6 7 8秒,安装完成

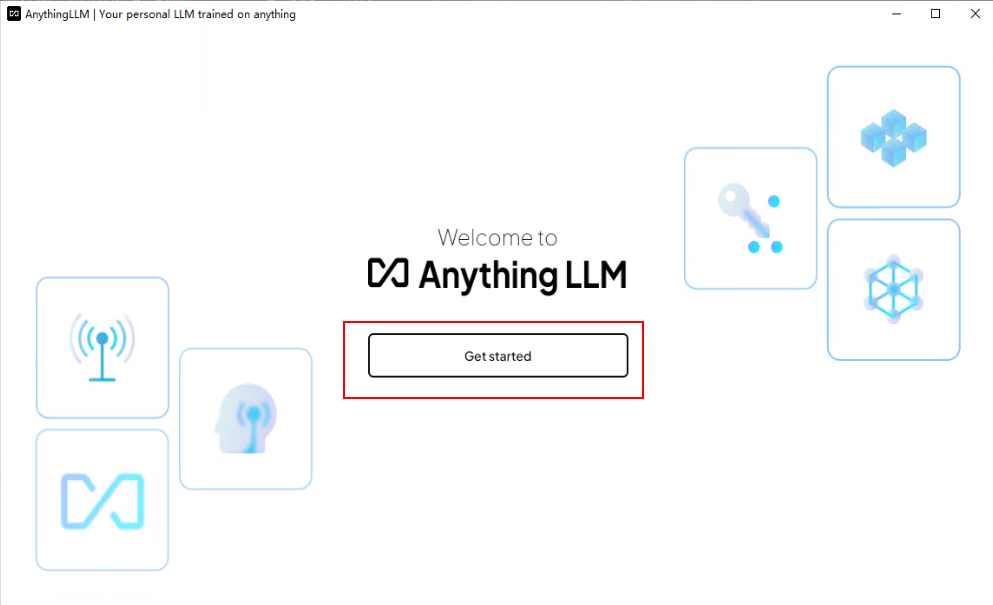

配置AnythingLLM

点击开始

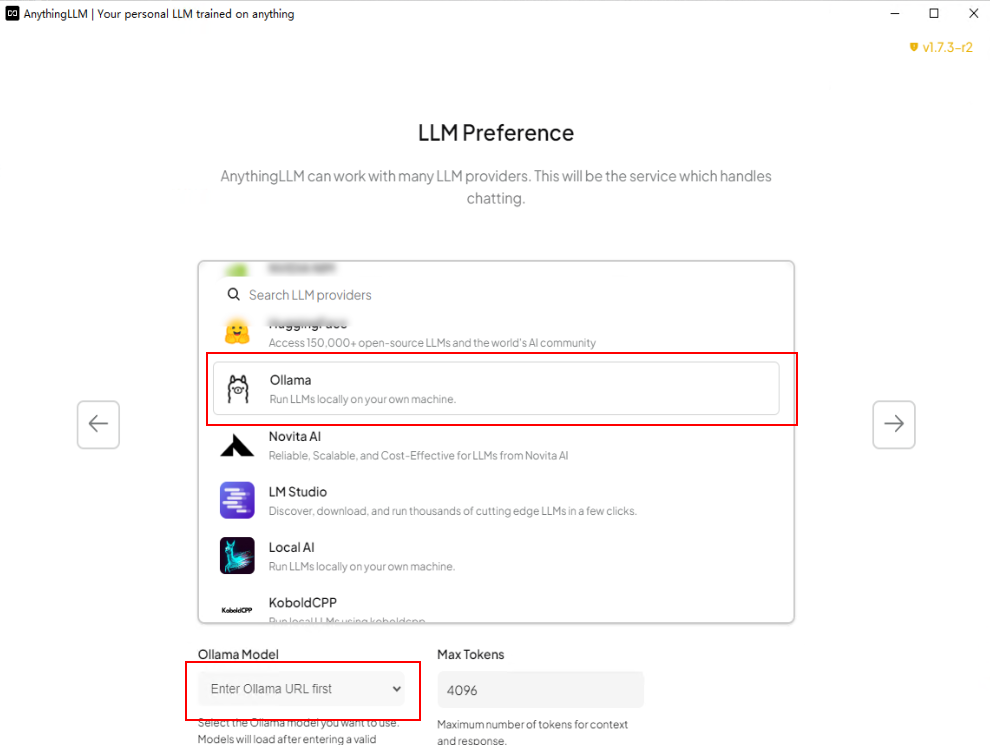

选择ollama,下方"ollama model"选择前面下载的模型

跳过调查问卷(想填也不是不行)

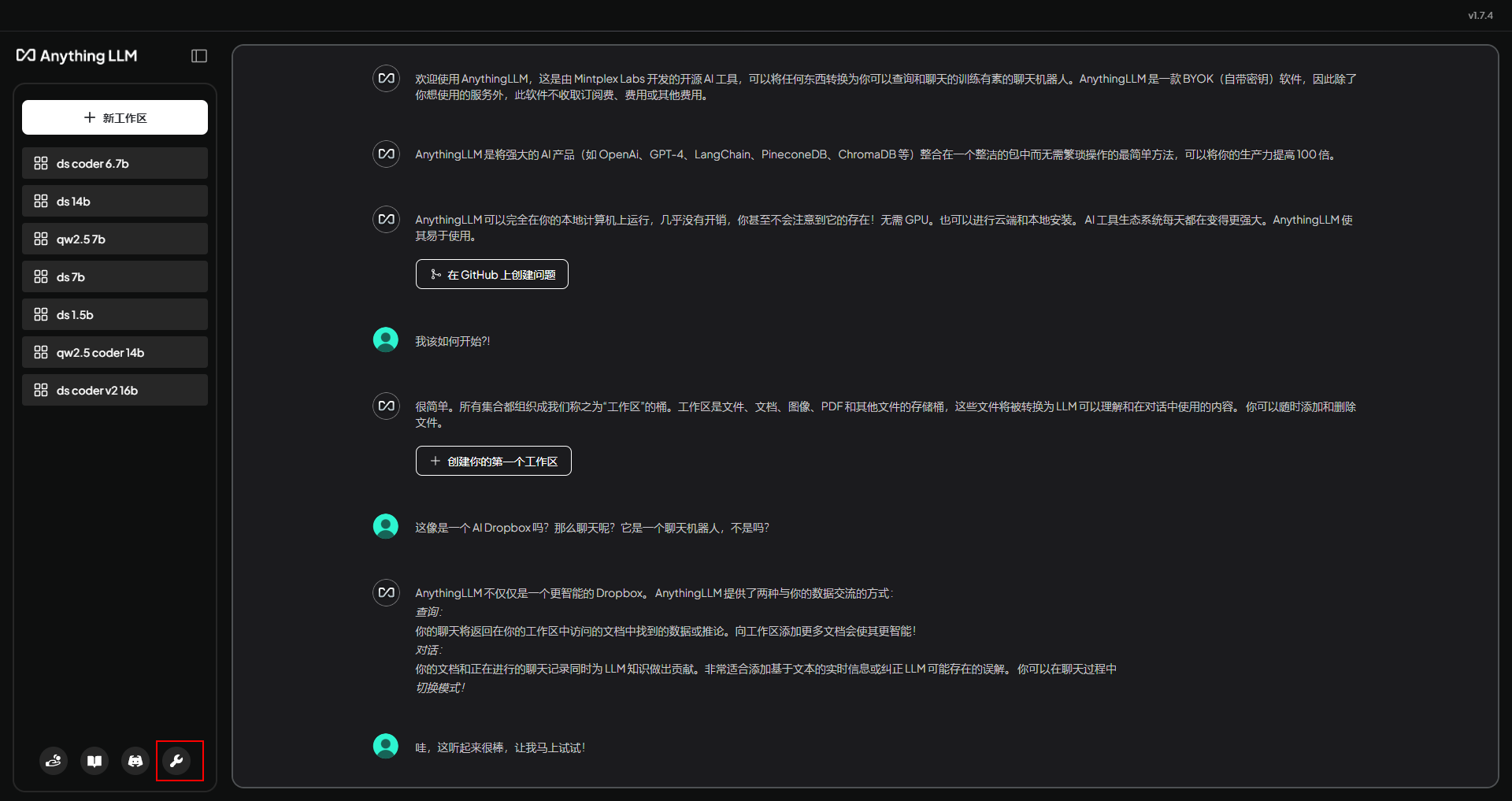

首先点击左下角设置

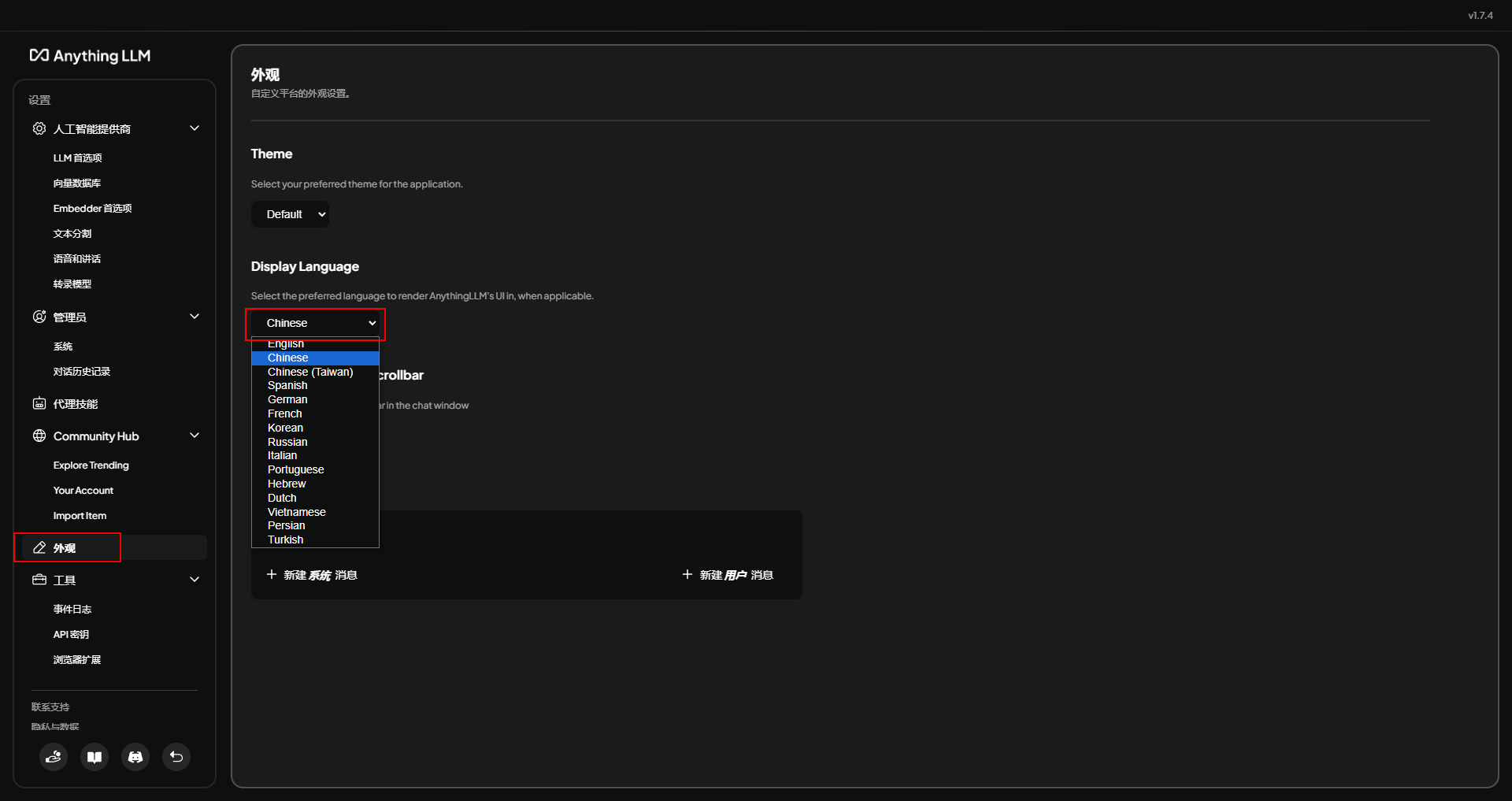

设置语言

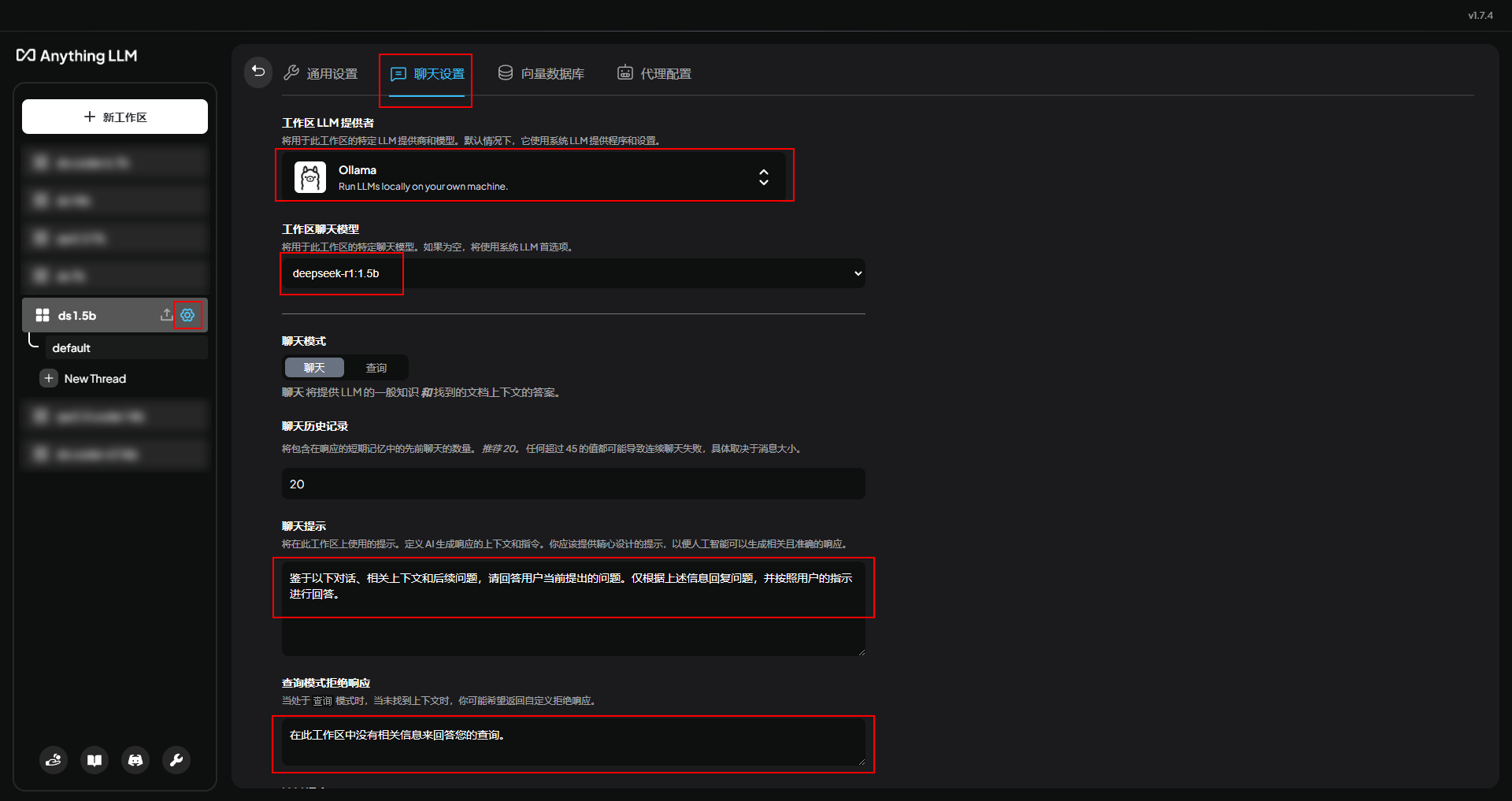

接下来设置刚刚新建的工作区,设置聊天的模型和提示语,提示语尽量为中文,软件默认的是英文,这样会导致模型小概率使用英文回答,后面如果新增工作区也是同样的设置方法

鉴于以下对话、相关上下文和后续问题,请回答用户当前提出的问题。仅根据上述信息回复问题,并按照用户的指示进行回答。

在此工作区中没有相关信息来回答您的查询。

下滑到最底部点击保存

另外,这里的LLM温度设置,可以参考deepseek官方给出的建议,根据自己的需求进行设置,以保证得到更合适的回复 Temperature 设置 | DeepSeek API Docs

| 场景 | 温度 |

|---|---|

| 代码生成/数学解题 | 0.0 |

| 数据抽取/分析 | 1.0 |

| 通用对话 | 1.3 |

| 翻译 | 1.3 |

| 创意类写作/诗歌创作 | 1.5 |

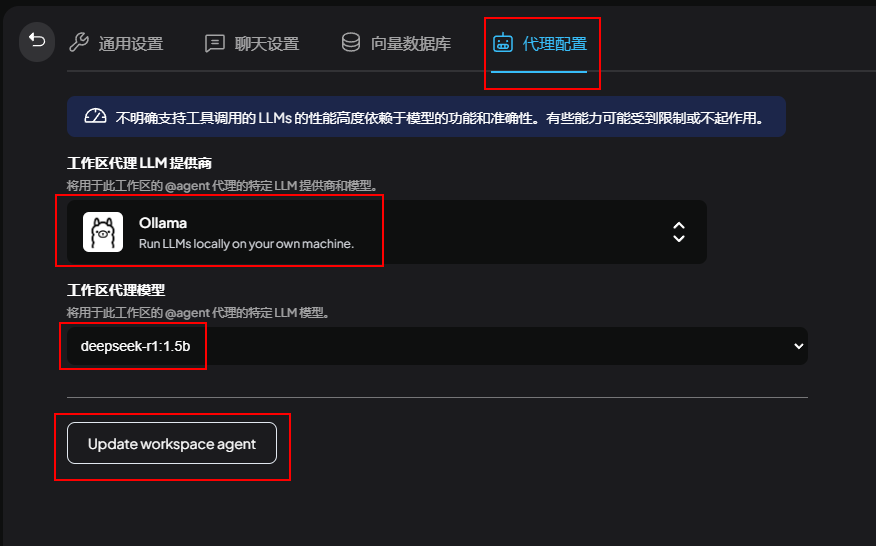

最后设置代理模型,这里的模型要和“聊天设置”里设置的相同,然后点击保存

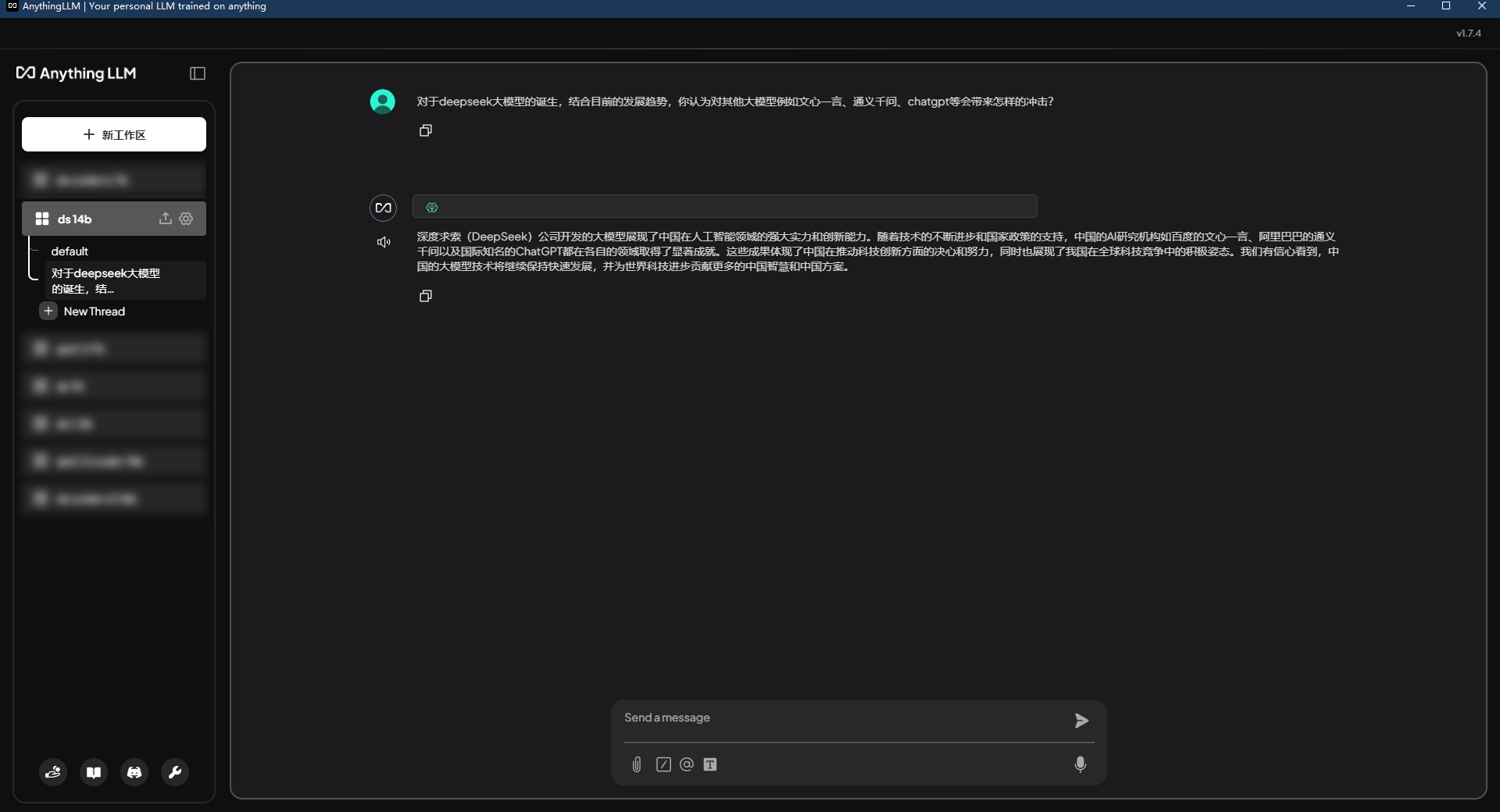

自此AnythingLLM的配置就完成了,可以进行愉快地体验啦

- 感谢你赐予我前进的力量